✨New

Get All Key Features for Just $6.99

KI-Lippensynchronisation: Warum sie wichtig ist und wann Sie sie wirklich brauchen

Zuletzt aktualisiert

19. Februar 2026

Jump to section

Jump to section

Jump to section

Jump to section

Zusammenfassen mit

Zusammenfassen mit

Zusammenfassen mit

Teilen

Teilen

Teilen

Ihr Marketingteam hat gerade die Aufnahme einer Produktankündigung abgeschlossen. Der CEO hat sie vor der Kamera gehalten. Der Ton wirkt selbstbewusst. Das Tempo ist natürlich.

Jetzt benötigen Sie Versionen in Spanisch, Deutsch und Japanisch für die weltweite Veröffentlichung nächste Woche.

Sie lassen das Video durch ein Synchronisationstool laufen. Die Übersetzung ist genau. Die neue Stimme klingt klar. Aber etwas fühlt sich falsch an. Die Mundbewegungen des Sprechers stimmen nicht mit den Worten überein.

Hier wird AI Lip Sync entscheidend. Die meisten Vermarkter, Kreativen und Produktteams nutzen einen AI Videoübersetzer mit AI Lip Sync, um Inhalte in mehrere Sprachen zu skalieren, ohne jedes Video von Grund auf neu erstellen zu müssen.

AI Lip Sync synchronisiert die übersetzte Sprachaufnahme mit den Mundbewegungen des Sprechers, sodass das Video in der Zielsprache natürlich aussieht. Wir werden aufzeigen, wann Lip Sync sinnvoll ist, wann nicht und wie man einen verlässlichen Lokalisierungs-Workflow aufbaut, ohne jedes Video übermäßig zu bearbeiten.

Der einfache Grund, warum Zuschauer Lip Sync bemerken

Die meisten Zuschauer verzeihen kleine Timingprobleme bei Untertiteln. Sie verzeihen selten ein Gesicht, das eindeutig nicht mit den Worten übereinstimmt.

AI Lip Sync ist wichtig, weil es die Reaktion „etwas fühlt sich falsch an“ reduziert, die auftritt, wenn Audio und Mundbewegung nicht übereinstimmen. Diese Reaktion ist bei folgenden Formaten stärker ausgeprägt:

Talking-Head-Videos

Großaufnahmen bei Interviews

Von Gründern geführte Ankündigungen

Inhaltszeugnisse

Anzeigen im UGC-Stil

Wenn Inhalte auf Vertrauen, Klarheit oder Persönlichkeit beruhen, ist AI Lip Sync oft der Unterschied zwischen „das fühlt sich lokal an“ und „das fühlt sich nach Synchronisation an“.

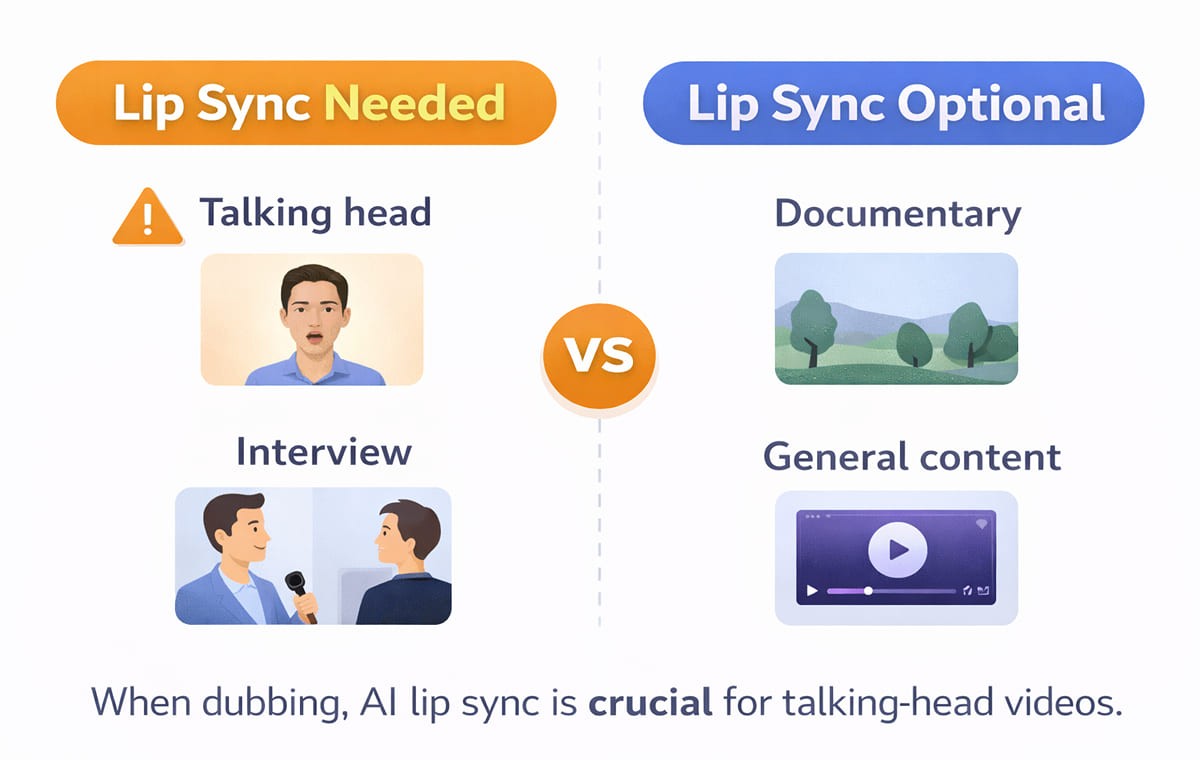

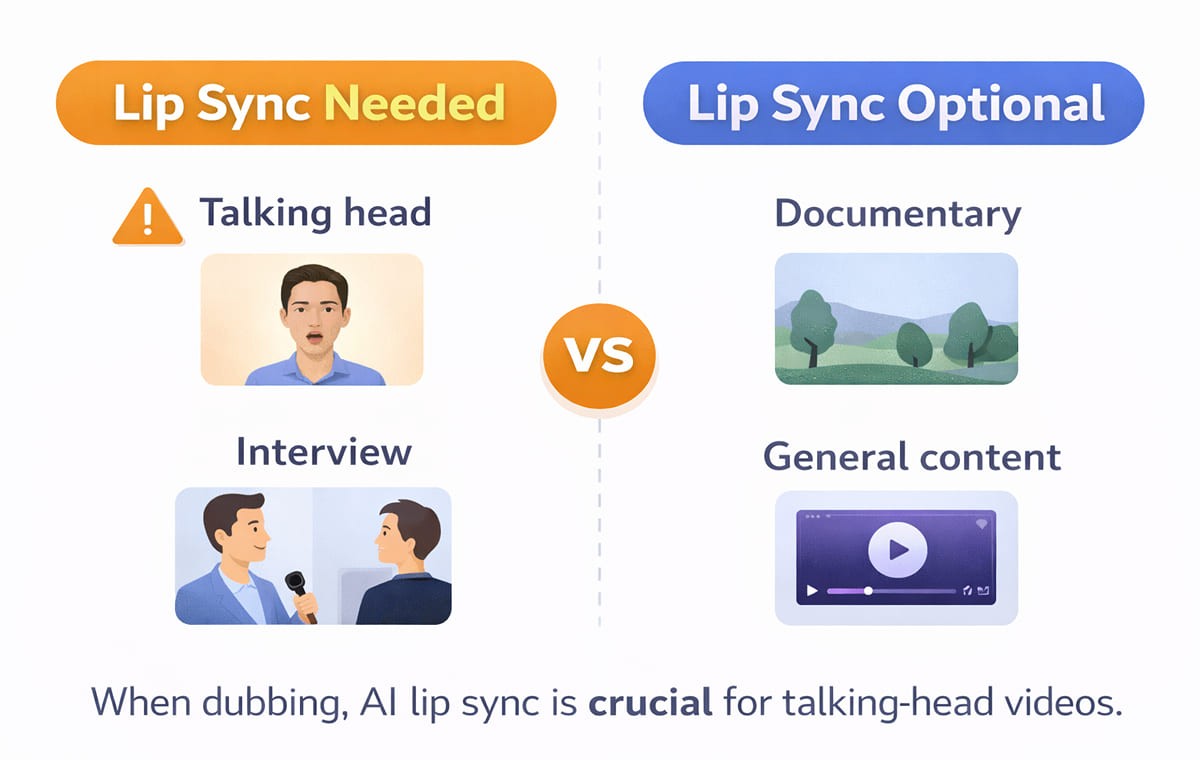

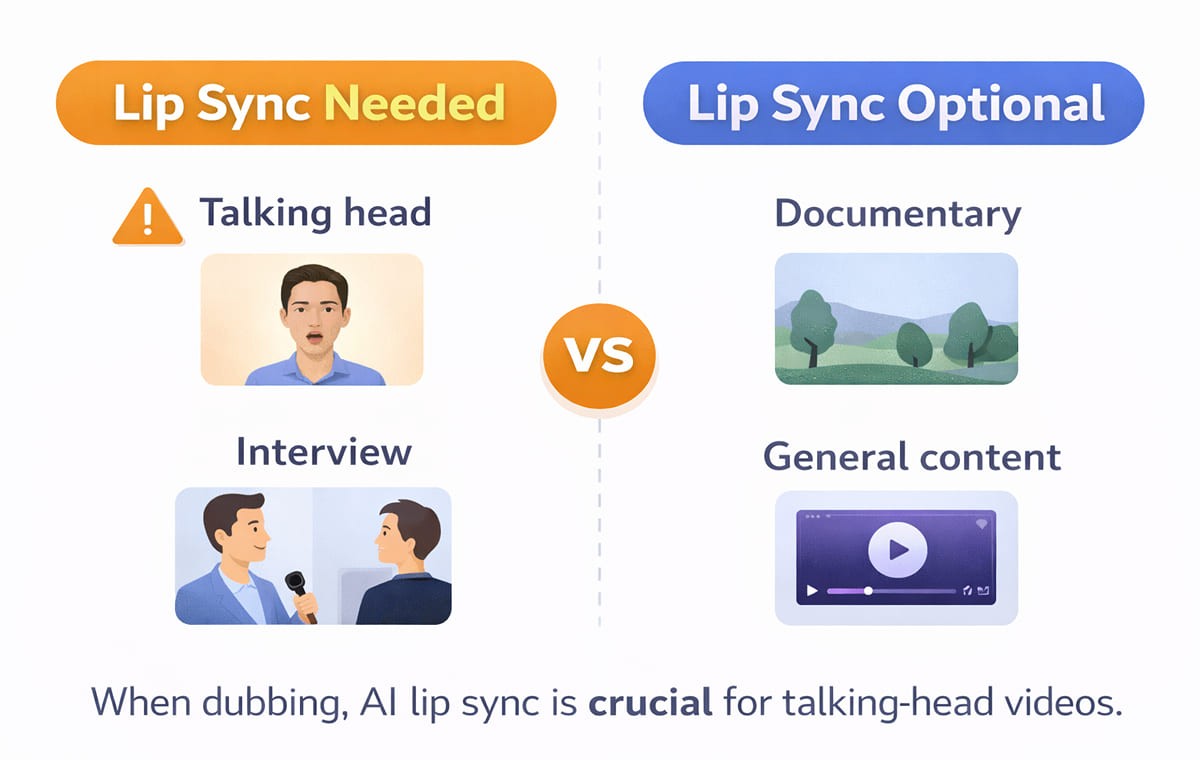

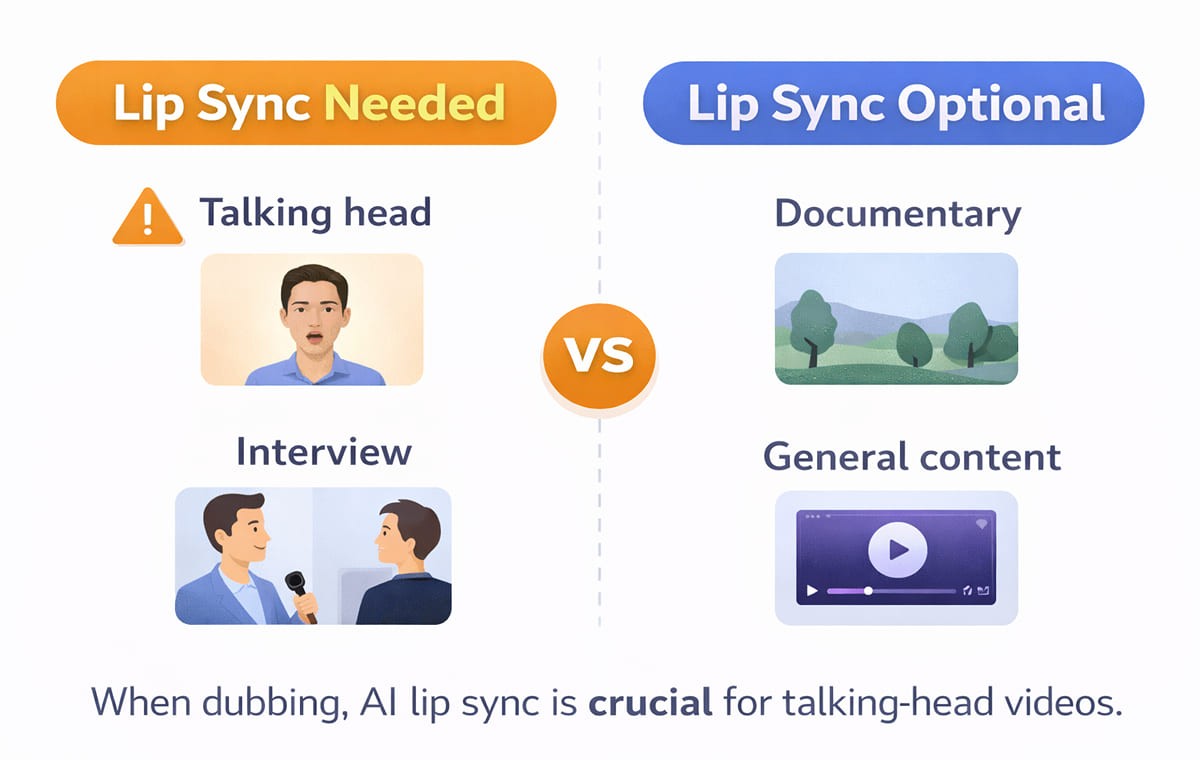

Wann ist AI Lip Sync ein Muss?

Wenn Sie entscheiden, wo Sie Ihre Mühe investieren, fangen Sie hier an. Lip Sync hat Priorität, wenn Ihr Video eines oder mehrere dieser Merkmale aufweist.

On-Camera-Sprechen ist das Hauptformat

Wenn das Gesicht des Sprechers lange zu sehen ist, sind Unstimmigkeiten offensichtlich. Dies ist das häufigste „Must-have“-Szenario für AI Lip Sync.

Ihre Markenstimme ist an eine reale Person gebunden

Wenn der Sprecher der Marken-CEO, Schöpfer, Trainer oder Sprecher ist, unterstützt Lip Sync die Glaubwürdigkeit. Dies passt natürlich zu Voice Cloning, wenn Sie in verschiedenen Sprachen eine konsistente Darstellung wünschen.

Sie betreiben performance-orientierte Kreativität

Bei Videoanzeigen sind kleine Vertrauenssignale wichtig. Wenn die Stimme nicht mit dem Mund übereinstimmt, scrollen die Zuschauer schneller weiter. Bei Kampagnen werden Arbeitsabläufe häufig auf Realismus und nicht auf „gut genug“ ausgerichtet.

Sie haben mehrere Sprecher

Podiumsdiskussionen und Interviews sind schwieriger als einfache Erzählungen. Wenn Ihr Tool mit mehreren Sprechern umgehen kann, unterstützt Lip Sync, dass jede Person nach dem Sprachwechsel konsistent wirkt.

Wann kann man auf Lip Sync verzichten, ohne es zu bereuen?

Sie benötigen nicht für jedes Projekt AI Lip Sync. In diesen Formaten kann es optional sein.

Bildschirmaufnahmen und Produktdemos

Wenn der Sprecher größtenteils nicht im Bild ist und der Inhalt sich auf die Benutzeroberfläche konzentriert, liegen Ihre Qualitätsmerkmale in Klarheit, Terminologie und Tempo. Lip Sync ist immer noch ein Bonus, aber nicht immer essenziell.

Folien, Animationen oder Voiceover-lastiger Inhalt

Wenn keine sichtbare Mundbewegung vorhanden ist, gibt es nichts zu synchronisieren. In diesen Fällen sind ein sauberer Videoübersetzungs-Workflow und Drehbuchbearbeitung wichtiger.

Intern-inhaltlicher Content mit geringer visueller Kontrolle

Einige interne Updates können zunächst Geschwindigkeit und Abdeckung priorisieren. Sie können später für externe Versionen ein Upgrade durchführen.

Was macht AI Lip Sync natürlich?

Die Qualität des Lip Syncs hängt nicht nur vom Mund ab. „Natürlich“ kommt in der Regel aus einer Kombination aus Timing, Sprachrealismus und Drehbuchpassung.

Timing, das zur Sprache passt

Verschiedene Sprachen dehnen oder komprimieren die Bedeutung. Gute Tools helfen dabei, das Tempo so zu synchronisieren, dass sich die synchronisierte Stimme nicht gehetzt oder gedehnt anfühlt.

Drehbuch, das wie ein Muttersprachler liest

Wenn die Übersetzung wörtlich ist, kann sie auch mit perfekter Synchronisation unnatürlich klingen. Deshalb ist ein Untertitel- und Drehbucheditor vor dem endgültigen Export wichtig.

Stimmqualität, die zum Sprecher passt

Wenn die Stimme für die Person auf dem Bildschirm falsch klingt, bemerken die Zuschauer dies sofort. Hierbei können Voice Cloning oder gut abgestimmte Stimmen dazu beitragen, die Glaubwürdigkeit der Darstellung zu wahren.

Eine schnelle Entscheidungstabelle

Verwenden Sie diese Tabelle als einfache „brauchen wir es“-Filter.

Videotyp | Benötigen Sie AI Lip Sync? | Warum es wichtig ist |

Talking-Head-Videos, Interviews, Testimonials | In der Regel ja | Mundinkongruenz ist sofort sichtbar |

UGC-Stil Videoanzeigen | Oft ja | Vertrauen und Authentizität treiben die Performance |

Webinare und Podiumsdiskussionen | Oft ja | Mehrere Sprecher verstärken das Risiko von Inkongruenzen |

Produktdemos (meist Bildschirm) | Manchmal | Klarheit und Drehbuchpassung sind wichtiger |

Animationen und Folien | Nein | Keine sichtbare Mundbewegung zur Synchronisation |

Was Sie überprüfen sollten, bevor Sie synchronisierte Videos veröffentlichen

Wenn Sie in eine andere Sprache synchronisieren, verhindern diese Überprüfungen die meisten „offensichtlich synchronisierten“ Ergebnisse.

Überprüfen Sie zuerst das Lip Sync bei Nahaufnahmen

Beurteilen Sie keine Weitwinkelaufnahmen. Überprüfen Sie die Momente, in denen der Sprecher den Rahmen füllt.

Bestätigen Sie, dass das Drehbuch dem entspricht, was der Mund „verkaufen“ kann

Einige Phrasen sehen in bestimmten Sprachen auf dem Mund ungeschickt aus. Kleine Drehbuchänderungen können das visuelle Gefühl natürlicher machen.

Achten Sie auf Aussprache und Markenausdrücke

Wenn Sie Produktnamen, Abkürzungen oder Markenbegriffe verwenden, nutzen Sie einen Workflow, der eine konsistente Handhabung unterstützt. Viele Teams kombinieren ein Glossar mit der Drehbuchüberprüfung vor dem Export.

Validieren Sie den Workflow auf Ihren realen Distributionsplattformen

Testen Sie den synchronisierten Export auf Ihren tatsächlichen Kanälen. Anzeigen, YouTube und Zielseiten können Probleme unterschiedlich offenbaren.

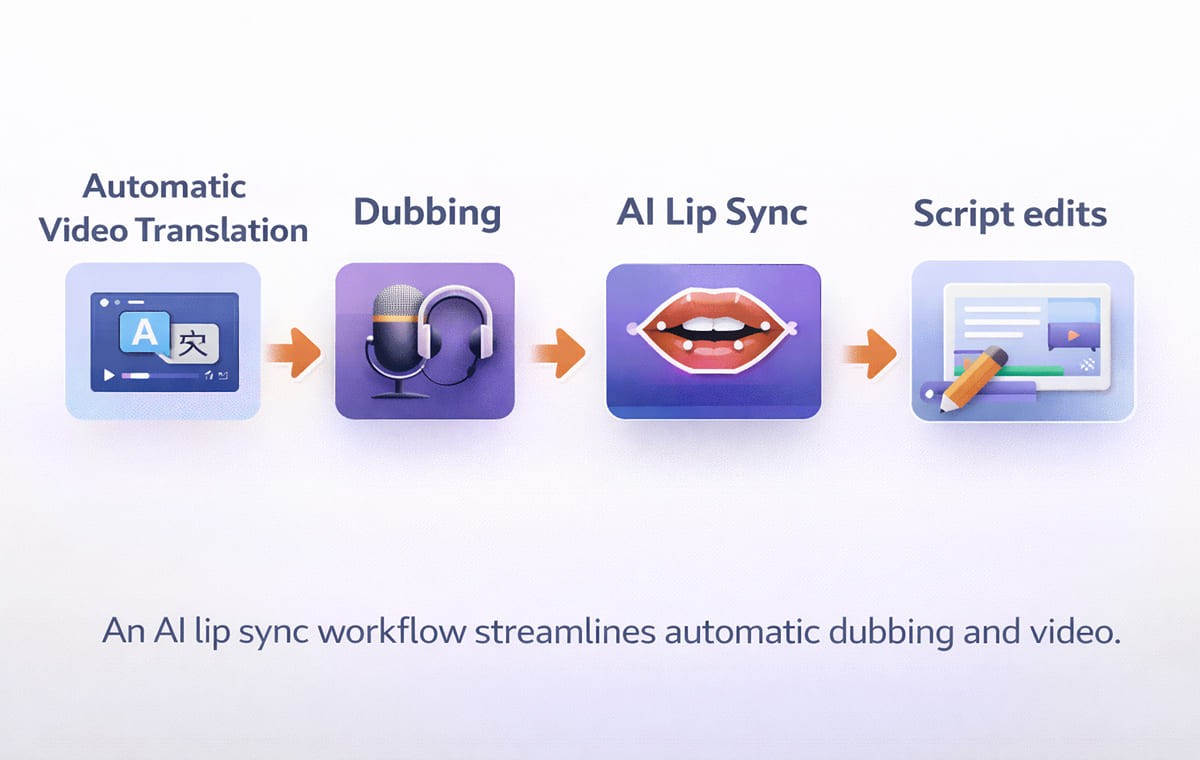

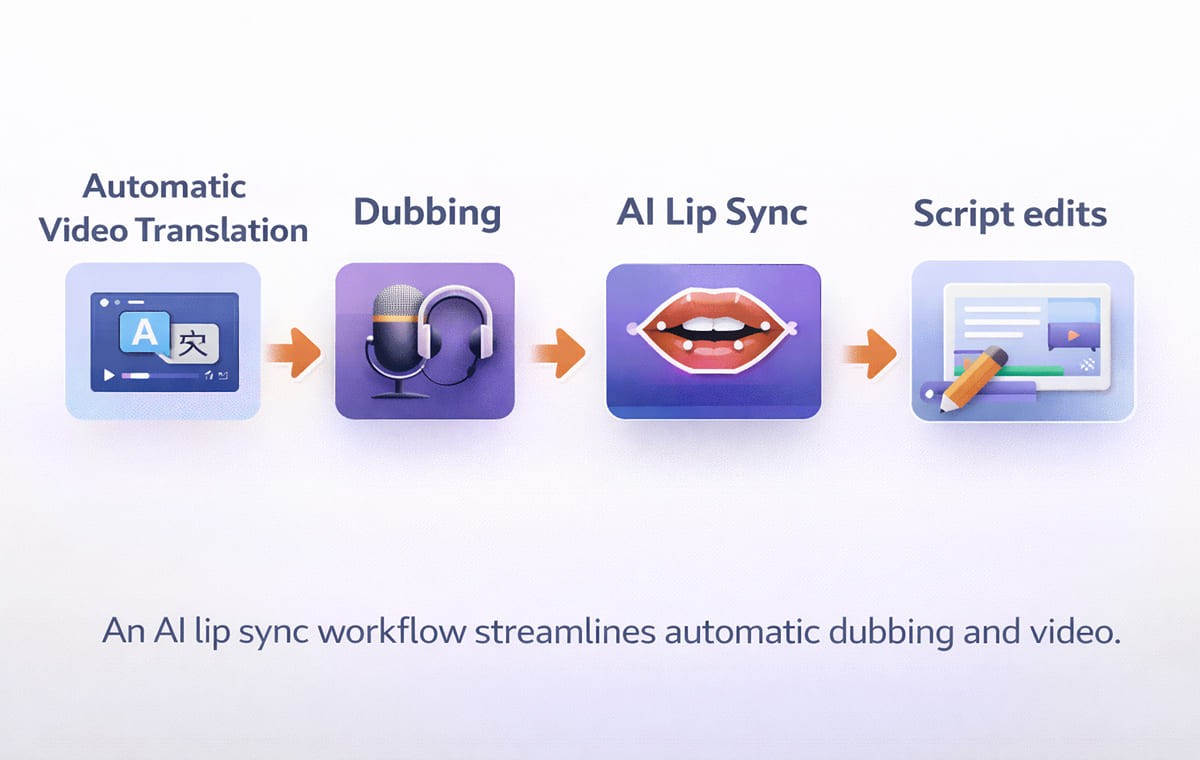

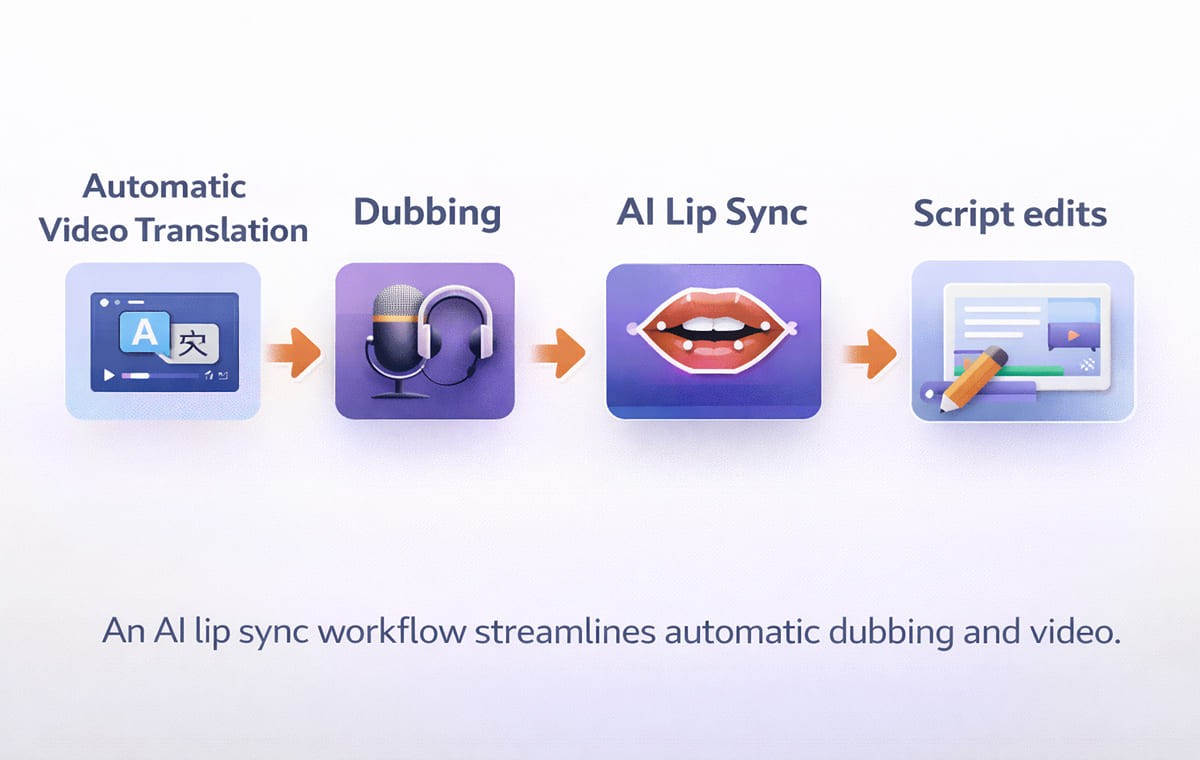

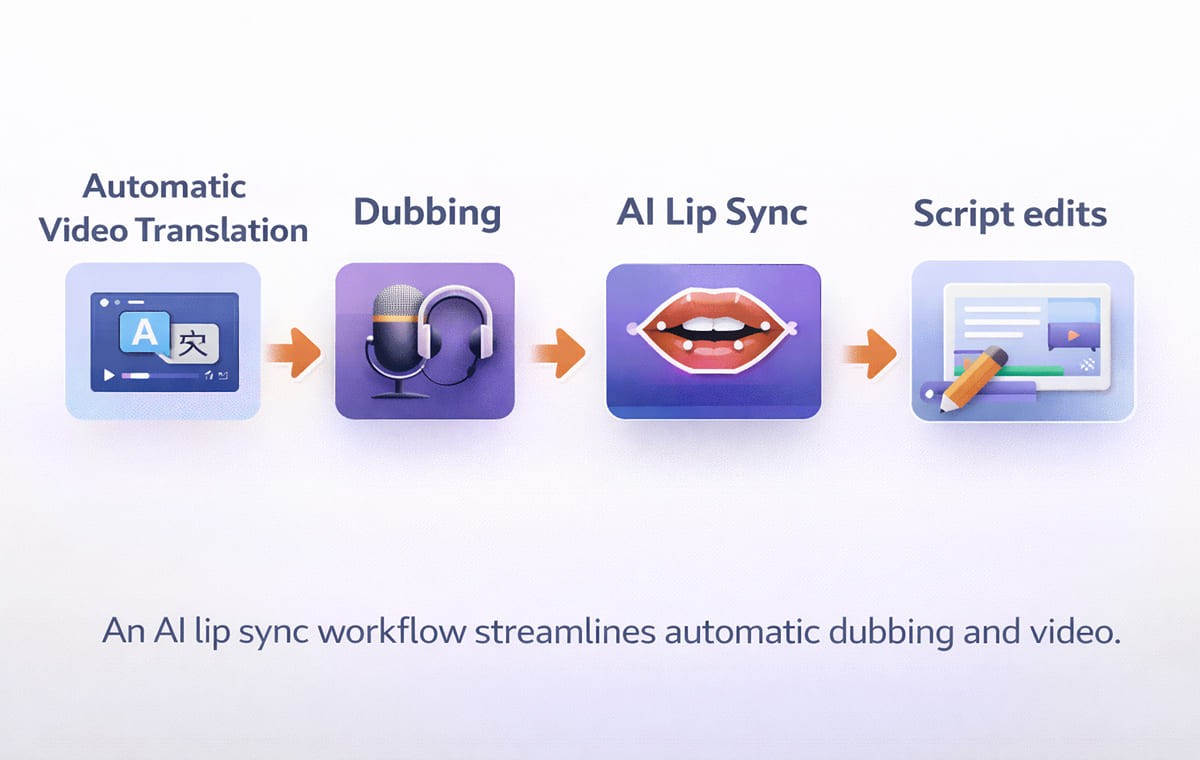

Wo AI Lip Sync in einen modernen Synchronisierungsworkflow passt

Die meisten Teams betrachten AI Lip Sync als einen Teil eines größeren Systems:

Das Video transkribieren

Das Drehbuch übersetzen

Synchronisierte Sprachaufnahme erzeugen

Lip Sync anwenden

Zeilen bearbeiten, die sich nicht natürlich anfühlen

Exportieren und veröffentlichen

Wenn Sie Automatische Synchronisation über mehrere Videos pro Woche skalieren möchten, ist das Ziel die Wiederholbarkeit. Eine Plattform, die Synchronisation, Übersetzung und Bearbeitung in einem Workflow kombiniert, reduziert das Hin und Her.

Häufig gestellte Fragen

1. Ist AI Lip Sync in jeder Sprache wichtig?

Nicht immer. Es ist am wichtigsten, wenn das Gesicht des Sprechers sichtbar ist und das Publikum auf natürliche Wiedergabe wartet. Für reine Voiceover-Inhalte ist es weniger relevant.

2. Kann ich AI Lip Sync ohne Voice Cloning verwenden?

Ja. Lip Sync synchronisiert visuelle Darstellungen mit dem Audio. Voice Cloning geht darum, die Identität oder den Ton des Sprechers in mehreren Sprachen zu bewahren.

3. Was ist der Unterschied zwischen Untertiteln und AI Lip Sync?

Untertitel helfen Menschen beim Lesen. AI Lip Sync hilft Menschen zu glauben, dass die synchronisierte Stimme dem Sprecher auf dem Bildschirm gehört. Viele Teams verwenden je nach Kanal beide Möglichkeiten.

4. Ist AI Lip Sync hauptsächlich für Kreative oder Unternehmen?

Beides. YouTube-Kreative verwenden automatische Synchronisation für AI-Videoübersetzung, um globale Zielgruppen zu vergrößern. Unternehmen nutzen es, um Anzeigen, Schulungen und Produktmarketing zu lokalisieren, ohne Inhalte neu zu erstellen.

5. Wie entscheide ich, ob ein Videoübersetzer gut genug ist?

Testen Sie ein echtes Video, nicht ein Demo. Überprüfen Sie Nahaufnahmen, prüfen Sie die Kontrolle der Drehbuchbearbeitung und bestätigen Sie, dass Ihre Terminologie über Exporte hinweg konsistent bleibt.

Fazit

AI Lip Sync ist wichtig, wenn Ihr Inhalt auf kamera-basiertem Vertrauen, Talking-Heads, Testimonials, Kreativvideos und kreativer Werbung basiert. Wenn Sie jedoch ein meist bildschirmbasiertes oder animiertes Format haben, können Sie in der Regel zuerst an der Qualität des Drehbuchs und der Klarheit der Synchronisation arbeiten und danach an Lip Sync, wenn die visuellen Anforderungen es erfordern.

Für U.S.-zuerst agierende Teams, die global skalieren, ist der beste Ansatz einfach: Setzen Sie Perso AI Lip Sync da ein, wo der Betrachter den Mund sehen kann und wo Glaubwürdigkeit die Ergebnisse beeinflusst, und halten Sie Ihren Synchronisations, Videoübersetzer und Automatischen Synchronisations-Workflow konsistent mit wiederholbaren Überprüfungen vor der Veröffentlichung.

Ihr Marketingteam hat gerade die Aufnahme einer Produktankündigung abgeschlossen. Der CEO hat sie vor der Kamera gehalten. Der Ton wirkt selbstbewusst. Das Tempo ist natürlich.

Jetzt benötigen Sie Versionen in Spanisch, Deutsch und Japanisch für die weltweite Veröffentlichung nächste Woche.

Sie lassen das Video durch ein Synchronisationstool laufen. Die Übersetzung ist genau. Die neue Stimme klingt klar. Aber etwas fühlt sich falsch an. Die Mundbewegungen des Sprechers stimmen nicht mit den Worten überein.

Hier wird AI Lip Sync entscheidend. Die meisten Vermarkter, Kreativen und Produktteams nutzen einen AI Videoübersetzer mit AI Lip Sync, um Inhalte in mehrere Sprachen zu skalieren, ohne jedes Video von Grund auf neu erstellen zu müssen.

AI Lip Sync synchronisiert die übersetzte Sprachaufnahme mit den Mundbewegungen des Sprechers, sodass das Video in der Zielsprache natürlich aussieht. Wir werden aufzeigen, wann Lip Sync sinnvoll ist, wann nicht und wie man einen verlässlichen Lokalisierungs-Workflow aufbaut, ohne jedes Video übermäßig zu bearbeiten.

Der einfache Grund, warum Zuschauer Lip Sync bemerken

Die meisten Zuschauer verzeihen kleine Timingprobleme bei Untertiteln. Sie verzeihen selten ein Gesicht, das eindeutig nicht mit den Worten übereinstimmt.

AI Lip Sync ist wichtig, weil es die Reaktion „etwas fühlt sich falsch an“ reduziert, die auftritt, wenn Audio und Mundbewegung nicht übereinstimmen. Diese Reaktion ist bei folgenden Formaten stärker ausgeprägt:

Talking-Head-Videos

Großaufnahmen bei Interviews

Von Gründern geführte Ankündigungen

Inhaltszeugnisse

Anzeigen im UGC-Stil

Wenn Inhalte auf Vertrauen, Klarheit oder Persönlichkeit beruhen, ist AI Lip Sync oft der Unterschied zwischen „das fühlt sich lokal an“ und „das fühlt sich nach Synchronisation an“.

Wann ist AI Lip Sync ein Muss?

Wenn Sie entscheiden, wo Sie Ihre Mühe investieren, fangen Sie hier an. Lip Sync hat Priorität, wenn Ihr Video eines oder mehrere dieser Merkmale aufweist.

On-Camera-Sprechen ist das Hauptformat

Wenn das Gesicht des Sprechers lange zu sehen ist, sind Unstimmigkeiten offensichtlich. Dies ist das häufigste „Must-have“-Szenario für AI Lip Sync.

Ihre Markenstimme ist an eine reale Person gebunden

Wenn der Sprecher der Marken-CEO, Schöpfer, Trainer oder Sprecher ist, unterstützt Lip Sync die Glaubwürdigkeit. Dies passt natürlich zu Voice Cloning, wenn Sie in verschiedenen Sprachen eine konsistente Darstellung wünschen.

Sie betreiben performance-orientierte Kreativität

Bei Videoanzeigen sind kleine Vertrauenssignale wichtig. Wenn die Stimme nicht mit dem Mund übereinstimmt, scrollen die Zuschauer schneller weiter. Bei Kampagnen werden Arbeitsabläufe häufig auf Realismus und nicht auf „gut genug“ ausgerichtet.

Sie haben mehrere Sprecher

Podiumsdiskussionen und Interviews sind schwieriger als einfache Erzählungen. Wenn Ihr Tool mit mehreren Sprechern umgehen kann, unterstützt Lip Sync, dass jede Person nach dem Sprachwechsel konsistent wirkt.

Wann kann man auf Lip Sync verzichten, ohne es zu bereuen?

Sie benötigen nicht für jedes Projekt AI Lip Sync. In diesen Formaten kann es optional sein.

Bildschirmaufnahmen und Produktdemos

Wenn der Sprecher größtenteils nicht im Bild ist und der Inhalt sich auf die Benutzeroberfläche konzentriert, liegen Ihre Qualitätsmerkmale in Klarheit, Terminologie und Tempo. Lip Sync ist immer noch ein Bonus, aber nicht immer essenziell.

Folien, Animationen oder Voiceover-lastiger Inhalt

Wenn keine sichtbare Mundbewegung vorhanden ist, gibt es nichts zu synchronisieren. In diesen Fällen sind ein sauberer Videoübersetzungs-Workflow und Drehbuchbearbeitung wichtiger.

Intern-inhaltlicher Content mit geringer visueller Kontrolle

Einige interne Updates können zunächst Geschwindigkeit und Abdeckung priorisieren. Sie können später für externe Versionen ein Upgrade durchführen.

Was macht AI Lip Sync natürlich?

Die Qualität des Lip Syncs hängt nicht nur vom Mund ab. „Natürlich“ kommt in der Regel aus einer Kombination aus Timing, Sprachrealismus und Drehbuchpassung.

Timing, das zur Sprache passt

Verschiedene Sprachen dehnen oder komprimieren die Bedeutung. Gute Tools helfen dabei, das Tempo so zu synchronisieren, dass sich die synchronisierte Stimme nicht gehetzt oder gedehnt anfühlt.

Drehbuch, das wie ein Muttersprachler liest

Wenn die Übersetzung wörtlich ist, kann sie auch mit perfekter Synchronisation unnatürlich klingen. Deshalb ist ein Untertitel- und Drehbucheditor vor dem endgültigen Export wichtig.

Stimmqualität, die zum Sprecher passt

Wenn die Stimme für die Person auf dem Bildschirm falsch klingt, bemerken die Zuschauer dies sofort. Hierbei können Voice Cloning oder gut abgestimmte Stimmen dazu beitragen, die Glaubwürdigkeit der Darstellung zu wahren.

Eine schnelle Entscheidungstabelle

Verwenden Sie diese Tabelle als einfache „brauchen wir es“-Filter.

Videotyp | Benötigen Sie AI Lip Sync? | Warum es wichtig ist |

Talking-Head-Videos, Interviews, Testimonials | In der Regel ja | Mundinkongruenz ist sofort sichtbar |

UGC-Stil Videoanzeigen | Oft ja | Vertrauen und Authentizität treiben die Performance |

Webinare und Podiumsdiskussionen | Oft ja | Mehrere Sprecher verstärken das Risiko von Inkongruenzen |

Produktdemos (meist Bildschirm) | Manchmal | Klarheit und Drehbuchpassung sind wichtiger |

Animationen und Folien | Nein | Keine sichtbare Mundbewegung zur Synchronisation |

Was Sie überprüfen sollten, bevor Sie synchronisierte Videos veröffentlichen

Wenn Sie in eine andere Sprache synchronisieren, verhindern diese Überprüfungen die meisten „offensichtlich synchronisierten“ Ergebnisse.

Überprüfen Sie zuerst das Lip Sync bei Nahaufnahmen

Beurteilen Sie keine Weitwinkelaufnahmen. Überprüfen Sie die Momente, in denen der Sprecher den Rahmen füllt.

Bestätigen Sie, dass das Drehbuch dem entspricht, was der Mund „verkaufen“ kann

Einige Phrasen sehen in bestimmten Sprachen auf dem Mund ungeschickt aus. Kleine Drehbuchänderungen können das visuelle Gefühl natürlicher machen.

Achten Sie auf Aussprache und Markenausdrücke

Wenn Sie Produktnamen, Abkürzungen oder Markenbegriffe verwenden, nutzen Sie einen Workflow, der eine konsistente Handhabung unterstützt. Viele Teams kombinieren ein Glossar mit der Drehbuchüberprüfung vor dem Export.

Validieren Sie den Workflow auf Ihren realen Distributionsplattformen

Testen Sie den synchronisierten Export auf Ihren tatsächlichen Kanälen. Anzeigen, YouTube und Zielseiten können Probleme unterschiedlich offenbaren.

Wo AI Lip Sync in einen modernen Synchronisierungsworkflow passt

Die meisten Teams betrachten AI Lip Sync als einen Teil eines größeren Systems:

Das Video transkribieren

Das Drehbuch übersetzen

Synchronisierte Sprachaufnahme erzeugen

Lip Sync anwenden

Zeilen bearbeiten, die sich nicht natürlich anfühlen

Exportieren und veröffentlichen

Wenn Sie Automatische Synchronisation über mehrere Videos pro Woche skalieren möchten, ist das Ziel die Wiederholbarkeit. Eine Plattform, die Synchronisation, Übersetzung und Bearbeitung in einem Workflow kombiniert, reduziert das Hin und Her.

Häufig gestellte Fragen

1. Ist AI Lip Sync in jeder Sprache wichtig?

Nicht immer. Es ist am wichtigsten, wenn das Gesicht des Sprechers sichtbar ist und das Publikum auf natürliche Wiedergabe wartet. Für reine Voiceover-Inhalte ist es weniger relevant.

2. Kann ich AI Lip Sync ohne Voice Cloning verwenden?

Ja. Lip Sync synchronisiert visuelle Darstellungen mit dem Audio. Voice Cloning geht darum, die Identität oder den Ton des Sprechers in mehreren Sprachen zu bewahren.

3. Was ist der Unterschied zwischen Untertiteln und AI Lip Sync?

Untertitel helfen Menschen beim Lesen. AI Lip Sync hilft Menschen zu glauben, dass die synchronisierte Stimme dem Sprecher auf dem Bildschirm gehört. Viele Teams verwenden je nach Kanal beide Möglichkeiten.

4. Ist AI Lip Sync hauptsächlich für Kreative oder Unternehmen?

Beides. YouTube-Kreative verwenden automatische Synchronisation für AI-Videoübersetzung, um globale Zielgruppen zu vergrößern. Unternehmen nutzen es, um Anzeigen, Schulungen und Produktmarketing zu lokalisieren, ohne Inhalte neu zu erstellen.

5. Wie entscheide ich, ob ein Videoübersetzer gut genug ist?

Testen Sie ein echtes Video, nicht ein Demo. Überprüfen Sie Nahaufnahmen, prüfen Sie die Kontrolle der Drehbuchbearbeitung und bestätigen Sie, dass Ihre Terminologie über Exporte hinweg konsistent bleibt.

Fazit

AI Lip Sync ist wichtig, wenn Ihr Inhalt auf kamera-basiertem Vertrauen, Talking-Heads, Testimonials, Kreativvideos und kreativer Werbung basiert. Wenn Sie jedoch ein meist bildschirmbasiertes oder animiertes Format haben, können Sie in der Regel zuerst an der Qualität des Drehbuchs und der Klarheit der Synchronisation arbeiten und danach an Lip Sync, wenn die visuellen Anforderungen es erfordern.

Für U.S.-zuerst agierende Teams, die global skalieren, ist der beste Ansatz einfach: Setzen Sie Perso AI Lip Sync da ein, wo der Betrachter den Mund sehen kann und wo Glaubwürdigkeit die Ergebnisse beeinflusst, und halten Sie Ihren Synchronisations, Videoübersetzer und Automatischen Synchronisations-Workflow konsistent mit wiederholbaren Überprüfungen vor der Veröffentlichung.

Ihr Marketingteam hat gerade die Aufnahme einer Produktankündigung abgeschlossen. Der CEO hat sie vor der Kamera gehalten. Der Ton wirkt selbstbewusst. Das Tempo ist natürlich.

Jetzt benötigen Sie Versionen in Spanisch, Deutsch und Japanisch für die weltweite Veröffentlichung nächste Woche.

Sie lassen das Video durch ein Synchronisationstool laufen. Die Übersetzung ist genau. Die neue Stimme klingt klar. Aber etwas fühlt sich falsch an. Die Mundbewegungen des Sprechers stimmen nicht mit den Worten überein.

Hier wird AI Lip Sync entscheidend. Die meisten Vermarkter, Kreativen und Produktteams nutzen einen AI Videoübersetzer mit AI Lip Sync, um Inhalte in mehrere Sprachen zu skalieren, ohne jedes Video von Grund auf neu erstellen zu müssen.

AI Lip Sync synchronisiert die übersetzte Sprachaufnahme mit den Mundbewegungen des Sprechers, sodass das Video in der Zielsprache natürlich aussieht. Wir werden aufzeigen, wann Lip Sync sinnvoll ist, wann nicht und wie man einen verlässlichen Lokalisierungs-Workflow aufbaut, ohne jedes Video übermäßig zu bearbeiten.

Der einfache Grund, warum Zuschauer Lip Sync bemerken

Die meisten Zuschauer verzeihen kleine Timingprobleme bei Untertiteln. Sie verzeihen selten ein Gesicht, das eindeutig nicht mit den Worten übereinstimmt.

AI Lip Sync ist wichtig, weil es die Reaktion „etwas fühlt sich falsch an“ reduziert, die auftritt, wenn Audio und Mundbewegung nicht übereinstimmen. Diese Reaktion ist bei folgenden Formaten stärker ausgeprägt:

Talking-Head-Videos

Großaufnahmen bei Interviews

Von Gründern geführte Ankündigungen

Inhaltszeugnisse

Anzeigen im UGC-Stil

Wenn Inhalte auf Vertrauen, Klarheit oder Persönlichkeit beruhen, ist AI Lip Sync oft der Unterschied zwischen „das fühlt sich lokal an“ und „das fühlt sich nach Synchronisation an“.

Wann ist AI Lip Sync ein Muss?

Wenn Sie entscheiden, wo Sie Ihre Mühe investieren, fangen Sie hier an. Lip Sync hat Priorität, wenn Ihr Video eines oder mehrere dieser Merkmale aufweist.

On-Camera-Sprechen ist das Hauptformat

Wenn das Gesicht des Sprechers lange zu sehen ist, sind Unstimmigkeiten offensichtlich. Dies ist das häufigste „Must-have“-Szenario für AI Lip Sync.

Ihre Markenstimme ist an eine reale Person gebunden

Wenn der Sprecher der Marken-CEO, Schöpfer, Trainer oder Sprecher ist, unterstützt Lip Sync die Glaubwürdigkeit. Dies passt natürlich zu Voice Cloning, wenn Sie in verschiedenen Sprachen eine konsistente Darstellung wünschen.

Sie betreiben performance-orientierte Kreativität

Bei Videoanzeigen sind kleine Vertrauenssignale wichtig. Wenn die Stimme nicht mit dem Mund übereinstimmt, scrollen die Zuschauer schneller weiter. Bei Kampagnen werden Arbeitsabläufe häufig auf Realismus und nicht auf „gut genug“ ausgerichtet.

Sie haben mehrere Sprecher

Podiumsdiskussionen und Interviews sind schwieriger als einfache Erzählungen. Wenn Ihr Tool mit mehreren Sprechern umgehen kann, unterstützt Lip Sync, dass jede Person nach dem Sprachwechsel konsistent wirkt.

Wann kann man auf Lip Sync verzichten, ohne es zu bereuen?

Sie benötigen nicht für jedes Projekt AI Lip Sync. In diesen Formaten kann es optional sein.

Bildschirmaufnahmen und Produktdemos

Wenn der Sprecher größtenteils nicht im Bild ist und der Inhalt sich auf die Benutzeroberfläche konzentriert, liegen Ihre Qualitätsmerkmale in Klarheit, Terminologie und Tempo. Lip Sync ist immer noch ein Bonus, aber nicht immer essenziell.

Folien, Animationen oder Voiceover-lastiger Inhalt

Wenn keine sichtbare Mundbewegung vorhanden ist, gibt es nichts zu synchronisieren. In diesen Fällen sind ein sauberer Videoübersetzungs-Workflow und Drehbuchbearbeitung wichtiger.

Intern-inhaltlicher Content mit geringer visueller Kontrolle

Einige interne Updates können zunächst Geschwindigkeit und Abdeckung priorisieren. Sie können später für externe Versionen ein Upgrade durchführen.

Was macht AI Lip Sync natürlich?

Die Qualität des Lip Syncs hängt nicht nur vom Mund ab. „Natürlich“ kommt in der Regel aus einer Kombination aus Timing, Sprachrealismus und Drehbuchpassung.

Timing, das zur Sprache passt

Verschiedene Sprachen dehnen oder komprimieren die Bedeutung. Gute Tools helfen dabei, das Tempo so zu synchronisieren, dass sich die synchronisierte Stimme nicht gehetzt oder gedehnt anfühlt.

Drehbuch, das wie ein Muttersprachler liest

Wenn die Übersetzung wörtlich ist, kann sie auch mit perfekter Synchronisation unnatürlich klingen. Deshalb ist ein Untertitel- und Drehbucheditor vor dem endgültigen Export wichtig.

Stimmqualität, die zum Sprecher passt

Wenn die Stimme für die Person auf dem Bildschirm falsch klingt, bemerken die Zuschauer dies sofort. Hierbei können Voice Cloning oder gut abgestimmte Stimmen dazu beitragen, die Glaubwürdigkeit der Darstellung zu wahren.

Eine schnelle Entscheidungstabelle

Verwenden Sie diese Tabelle als einfache „brauchen wir es“-Filter.

Videotyp | Benötigen Sie AI Lip Sync? | Warum es wichtig ist |

Talking-Head-Videos, Interviews, Testimonials | In der Regel ja | Mundinkongruenz ist sofort sichtbar |

UGC-Stil Videoanzeigen | Oft ja | Vertrauen und Authentizität treiben die Performance |

Webinare und Podiumsdiskussionen | Oft ja | Mehrere Sprecher verstärken das Risiko von Inkongruenzen |

Produktdemos (meist Bildschirm) | Manchmal | Klarheit und Drehbuchpassung sind wichtiger |

Animationen und Folien | Nein | Keine sichtbare Mundbewegung zur Synchronisation |

Was Sie überprüfen sollten, bevor Sie synchronisierte Videos veröffentlichen

Wenn Sie in eine andere Sprache synchronisieren, verhindern diese Überprüfungen die meisten „offensichtlich synchronisierten“ Ergebnisse.

Überprüfen Sie zuerst das Lip Sync bei Nahaufnahmen

Beurteilen Sie keine Weitwinkelaufnahmen. Überprüfen Sie die Momente, in denen der Sprecher den Rahmen füllt.

Bestätigen Sie, dass das Drehbuch dem entspricht, was der Mund „verkaufen“ kann

Einige Phrasen sehen in bestimmten Sprachen auf dem Mund ungeschickt aus. Kleine Drehbuchänderungen können das visuelle Gefühl natürlicher machen.

Achten Sie auf Aussprache und Markenausdrücke

Wenn Sie Produktnamen, Abkürzungen oder Markenbegriffe verwenden, nutzen Sie einen Workflow, der eine konsistente Handhabung unterstützt. Viele Teams kombinieren ein Glossar mit der Drehbuchüberprüfung vor dem Export.

Validieren Sie den Workflow auf Ihren realen Distributionsplattformen

Testen Sie den synchronisierten Export auf Ihren tatsächlichen Kanälen. Anzeigen, YouTube und Zielseiten können Probleme unterschiedlich offenbaren.

Wo AI Lip Sync in einen modernen Synchronisierungsworkflow passt

Die meisten Teams betrachten AI Lip Sync als einen Teil eines größeren Systems:

Das Video transkribieren

Das Drehbuch übersetzen

Synchronisierte Sprachaufnahme erzeugen

Lip Sync anwenden

Zeilen bearbeiten, die sich nicht natürlich anfühlen

Exportieren und veröffentlichen

Wenn Sie Automatische Synchronisation über mehrere Videos pro Woche skalieren möchten, ist das Ziel die Wiederholbarkeit. Eine Plattform, die Synchronisation, Übersetzung und Bearbeitung in einem Workflow kombiniert, reduziert das Hin und Her.

Häufig gestellte Fragen

1. Ist AI Lip Sync in jeder Sprache wichtig?

Nicht immer. Es ist am wichtigsten, wenn das Gesicht des Sprechers sichtbar ist und das Publikum auf natürliche Wiedergabe wartet. Für reine Voiceover-Inhalte ist es weniger relevant.

2. Kann ich AI Lip Sync ohne Voice Cloning verwenden?

Ja. Lip Sync synchronisiert visuelle Darstellungen mit dem Audio. Voice Cloning geht darum, die Identität oder den Ton des Sprechers in mehreren Sprachen zu bewahren.

3. Was ist der Unterschied zwischen Untertiteln und AI Lip Sync?

Untertitel helfen Menschen beim Lesen. AI Lip Sync hilft Menschen zu glauben, dass die synchronisierte Stimme dem Sprecher auf dem Bildschirm gehört. Viele Teams verwenden je nach Kanal beide Möglichkeiten.

4. Ist AI Lip Sync hauptsächlich für Kreative oder Unternehmen?

Beides. YouTube-Kreative verwenden automatische Synchronisation für AI-Videoübersetzung, um globale Zielgruppen zu vergrößern. Unternehmen nutzen es, um Anzeigen, Schulungen und Produktmarketing zu lokalisieren, ohne Inhalte neu zu erstellen.

5. Wie entscheide ich, ob ein Videoübersetzer gut genug ist?

Testen Sie ein echtes Video, nicht ein Demo. Überprüfen Sie Nahaufnahmen, prüfen Sie die Kontrolle der Drehbuchbearbeitung und bestätigen Sie, dass Ihre Terminologie über Exporte hinweg konsistent bleibt.

Fazit

AI Lip Sync ist wichtig, wenn Ihr Inhalt auf kamera-basiertem Vertrauen, Talking-Heads, Testimonials, Kreativvideos und kreativer Werbung basiert. Wenn Sie jedoch ein meist bildschirmbasiertes oder animiertes Format haben, können Sie in der Regel zuerst an der Qualität des Drehbuchs und der Klarheit der Synchronisation arbeiten und danach an Lip Sync, wenn die visuellen Anforderungen es erfordern.

Für U.S.-zuerst agierende Teams, die global skalieren, ist der beste Ansatz einfach: Setzen Sie Perso AI Lip Sync da ein, wo der Betrachter den Mund sehen kann und wo Glaubwürdigkeit die Ergebnisse beeinflusst, und halten Sie Ihren Synchronisations, Videoübersetzer und Automatischen Synchronisations-Workflow konsistent mit wiederholbaren Überprüfungen vor der Veröffentlichung.

Ihr Marketingteam hat gerade die Aufnahme einer Produktankündigung abgeschlossen. Der CEO hat sie vor der Kamera gehalten. Der Ton wirkt selbstbewusst. Das Tempo ist natürlich.

Jetzt benötigen Sie Versionen in Spanisch, Deutsch und Japanisch für die weltweite Veröffentlichung nächste Woche.

Sie lassen das Video durch ein Synchronisationstool laufen. Die Übersetzung ist genau. Die neue Stimme klingt klar. Aber etwas fühlt sich falsch an. Die Mundbewegungen des Sprechers stimmen nicht mit den Worten überein.

Hier wird AI Lip Sync entscheidend. Die meisten Vermarkter, Kreativen und Produktteams nutzen einen AI Videoübersetzer mit AI Lip Sync, um Inhalte in mehrere Sprachen zu skalieren, ohne jedes Video von Grund auf neu erstellen zu müssen.

AI Lip Sync synchronisiert die übersetzte Sprachaufnahme mit den Mundbewegungen des Sprechers, sodass das Video in der Zielsprache natürlich aussieht. Wir werden aufzeigen, wann Lip Sync sinnvoll ist, wann nicht und wie man einen verlässlichen Lokalisierungs-Workflow aufbaut, ohne jedes Video übermäßig zu bearbeiten.

Der einfache Grund, warum Zuschauer Lip Sync bemerken

Die meisten Zuschauer verzeihen kleine Timingprobleme bei Untertiteln. Sie verzeihen selten ein Gesicht, das eindeutig nicht mit den Worten übereinstimmt.

AI Lip Sync ist wichtig, weil es die Reaktion „etwas fühlt sich falsch an“ reduziert, die auftritt, wenn Audio und Mundbewegung nicht übereinstimmen. Diese Reaktion ist bei folgenden Formaten stärker ausgeprägt:

Talking-Head-Videos

Großaufnahmen bei Interviews

Von Gründern geführte Ankündigungen

Inhaltszeugnisse

Anzeigen im UGC-Stil

Wenn Inhalte auf Vertrauen, Klarheit oder Persönlichkeit beruhen, ist AI Lip Sync oft der Unterschied zwischen „das fühlt sich lokal an“ und „das fühlt sich nach Synchronisation an“.

Wann ist AI Lip Sync ein Muss?

Wenn Sie entscheiden, wo Sie Ihre Mühe investieren, fangen Sie hier an. Lip Sync hat Priorität, wenn Ihr Video eines oder mehrere dieser Merkmale aufweist.

On-Camera-Sprechen ist das Hauptformat

Wenn das Gesicht des Sprechers lange zu sehen ist, sind Unstimmigkeiten offensichtlich. Dies ist das häufigste „Must-have“-Szenario für AI Lip Sync.

Ihre Markenstimme ist an eine reale Person gebunden

Wenn der Sprecher der Marken-CEO, Schöpfer, Trainer oder Sprecher ist, unterstützt Lip Sync die Glaubwürdigkeit. Dies passt natürlich zu Voice Cloning, wenn Sie in verschiedenen Sprachen eine konsistente Darstellung wünschen.

Sie betreiben performance-orientierte Kreativität

Bei Videoanzeigen sind kleine Vertrauenssignale wichtig. Wenn die Stimme nicht mit dem Mund übereinstimmt, scrollen die Zuschauer schneller weiter. Bei Kampagnen werden Arbeitsabläufe häufig auf Realismus und nicht auf „gut genug“ ausgerichtet.

Sie haben mehrere Sprecher

Podiumsdiskussionen und Interviews sind schwieriger als einfache Erzählungen. Wenn Ihr Tool mit mehreren Sprechern umgehen kann, unterstützt Lip Sync, dass jede Person nach dem Sprachwechsel konsistent wirkt.

Wann kann man auf Lip Sync verzichten, ohne es zu bereuen?

Sie benötigen nicht für jedes Projekt AI Lip Sync. In diesen Formaten kann es optional sein.

Bildschirmaufnahmen und Produktdemos

Wenn der Sprecher größtenteils nicht im Bild ist und der Inhalt sich auf die Benutzeroberfläche konzentriert, liegen Ihre Qualitätsmerkmale in Klarheit, Terminologie und Tempo. Lip Sync ist immer noch ein Bonus, aber nicht immer essenziell.

Folien, Animationen oder Voiceover-lastiger Inhalt

Wenn keine sichtbare Mundbewegung vorhanden ist, gibt es nichts zu synchronisieren. In diesen Fällen sind ein sauberer Videoübersetzungs-Workflow und Drehbuchbearbeitung wichtiger.

Intern-inhaltlicher Content mit geringer visueller Kontrolle

Einige interne Updates können zunächst Geschwindigkeit und Abdeckung priorisieren. Sie können später für externe Versionen ein Upgrade durchführen.

Was macht AI Lip Sync natürlich?

Die Qualität des Lip Syncs hängt nicht nur vom Mund ab. „Natürlich“ kommt in der Regel aus einer Kombination aus Timing, Sprachrealismus und Drehbuchpassung.

Timing, das zur Sprache passt

Verschiedene Sprachen dehnen oder komprimieren die Bedeutung. Gute Tools helfen dabei, das Tempo so zu synchronisieren, dass sich die synchronisierte Stimme nicht gehetzt oder gedehnt anfühlt.

Drehbuch, das wie ein Muttersprachler liest

Wenn die Übersetzung wörtlich ist, kann sie auch mit perfekter Synchronisation unnatürlich klingen. Deshalb ist ein Untertitel- und Drehbucheditor vor dem endgültigen Export wichtig.

Stimmqualität, die zum Sprecher passt

Wenn die Stimme für die Person auf dem Bildschirm falsch klingt, bemerken die Zuschauer dies sofort. Hierbei können Voice Cloning oder gut abgestimmte Stimmen dazu beitragen, die Glaubwürdigkeit der Darstellung zu wahren.

Eine schnelle Entscheidungstabelle

Verwenden Sie diese Tabelle als einfache „brauchen wir es“-Filter.

Videotyp | Benötigen Sie AI Lip Sync? | Warum es wichtig ist |

Talking-Head-Videos, Interviews, Testimonials | In der Regel ja | Mundinkongruenz ist sofort sichtbar |

UGC-Stil Videoanzeigen | Oft ja | Vertrauen und Authentizität treiben die Performance |

Webinare und Podiumsdiskussionen | Oft ja | Mehrere Sprecher verstärken das Risiko von Inkongruenzen |

Produktdemos (meist Bildschirm) | Manchmal | Klarheit und Drehbuchpassung sind wichtiger |

Animationen und Folien | Nein | Keine sichtbare Mundbewegung zur Synchronisation |

Was Sie überprüfen sollten, bevor Sie synchronisierte Videos veröffentlichen

Wenn Sie in eine andere Sprache synchronisieren, verhindern diese Überprüfungen die meisten „offensichtlich synchronisierten“ Ergebnisse.

Überprüfen Sie zuerst das Lip Sync bei Nahaufnahmen

Beurteilen Sie keine Weitwinkelaufnahmen. Überprüfen Sie die Momente, in denen der Sprecher den Rahmen füllt.

Bestätigen Sie, dass das Drehbuch dem entspricht, was der Mund „verkaufen“ kann

Einige Phrasen sehen in bestimmten Sprachen auf dem Mund ungeschickt aus. Kleine Drehbuchänderungen können das visuelle Gefühl natürlicher machen.

Achten Sie auf Aussprache und Markenausdrücke

Wenn Sie Produktnamen, Abkürzungen oder Markenbegriffe verwenden, nutzen Sie einen Workflow, der eine konsistente Handhabung unterstützt. Viele Teams kombinieren ein Glossar mit der Drehbuchüberprüfung vor dem Export.

Validieren Sie den Workflow auf Ihren realen Distributionsplattformen

Testen Sie den synchronisierten Export auf Ihren tatsächlichen Kanälen. Anzeigen, YouTube und Zielseiten können Probleme unterschiedlich offenbaren.

Wo AI Lip Sync in einen modernen Synchronisierungsworkflow passt

Die meisten Teams betrachten AI Lip Sync als einen Teil eines größeren Systems:

Das Video transkribieren

Das Drehbuch übersetzen

Synchronisierte Sprachaufnahme erzeugen

Lip Sync anwenden

Zeilen bearbeiten, die sich nicht natürlich anfühlen

Exportieren und veröffentlichen

Wenn Sie Automatische Synchronisation über mehrere Videos pro Woche skalieren möchten, ist das Ziel die Wiederholbarkeit. Eine Plattform, die Synchronisation, Übersetzung und Bearbeitung in einem Workflow kombiniert, reduziert das Hin und Her.

Häufig gestellte Fragen

1. Ist AI Lip Sync in jeder Sprache wichtig?

Nicht immer. Es ist am wichtigsten, wenn das Gesicht des Sprechers sichtbar ist und das Publikum auf natürliche Wiedergabe wartet. Für reine Voiceover-Inhalte ist es weniger relevant.

2. Kann ich AI Lip Sync ohne Voice Cloning verwenden?

Ja. Lip Sync synchronisiert visuelle Darstellungen mit dem Audio. Voice Cloning geht darum, die Identität oder den Ton des Sprechers in mehreren Sprachen zu bewahren.

3. Was ist der Unterschied zwischen Untertiteln und AI Lip Sync?

Untertitel helfen Menschen beim Lesen. AI Lip Sync hilft Menschen zu glauben, dass die synchronisierte Stimme dem Sprecher auf dem Bildschirm gehört. Viele Teams verwenden je nach Kanal beide Möglichkeiten.

4. Ist AI Lip Sync hauptsächlich für Kreative oder Unternehmen?

Beides. YouTube-Kreative verwenden automatische Synchronisation für AI-Videoübersetzung, um globale Zielgruppen zu vergrößern. Unternehmen nutzen es, um Anzeigen, Schulungen und Produktmarketing zu lokalisieren, ohne Inhalte neu zu erstellen.

5. Wie entscheide ich, ob ein Videoübersetzer gut genug ist?

Testen Sie ein echtes Video, nicht ein Demo. Überprüfen Sie Nahaufnahmen, prüfen Sie die Kontrolle der Drehbuchbearbeitung und bestätigen Sie, dass Ihre Terminologie über Exporte hinweg konsistent bleibt.

Fazit

AI Lip Sync ist wichtig, wenn Ihr Inhalt auf kamera-basiertem Vertrauen, Talking-Heads, Testimonials, Kreativvideos und kreativer Werbung basiert. Wenn Sie jedoch ein meist bildschirmbasiertes oder animiertes Format haben, können Sie in der Regel zuerst an der Qualität des Drehbuchs und der Klarheit der Synchronisation arbeiten und danach an Lip Sync, wenn die visuellen Anforderungen es erfordern.

Für U.S.-zuerst agierende Teams, die global skalieren, ist der beste Ansatz einfach: Setzen Sie Perso AI Lip Sync da ein, wo der Betrachter den Mund sehen kann und wo Glaubwürdigkeit die Ergebnisse beeinflusst, und halten Sie Ihren Synchronisations, Videoübersetzer und Automatischen Synchronisations-Workflow konsistent mit wiederholbaren Überprüfungen vor der Veröffentlichung.

Weiterlesen

Alle durchsuchen

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618