✨New

Get All Key Features for Just $6.99

KI-Synchronisationsfunktionen: Was man bei einer Video-Synchronisationsplattform beachten sollte

Zuletzt aktualisiert

10. Februar 2026

AI Video-Übersetzer, Lokalisierung und Synchronisationswerkzeug

Probieren Sie es kostenlos aus

Jump to section

Jump to section

Teilen

Teilen

Teilen

KI-Dubbing-Funktionen, die wirklich wichtig sind: Ein praktischer Leitfaden

Ihr US-Team schließt ein Produktdemo-Video auf Englisch ab. Nächste Woche fragt der Vertrieb nach Spanisch. Der Support möchte Japanisch für APAC-Kunden. Das Marketing möchte dieselbe Stimme und das gleiche Tempo in jeder Sprache, damit die Marke immer noch „wie Sie klingt“.

Traditionelles Dubbing kann pro Sprache Wochen dauern und wird schnell teuer, wenn man Übersetzer, Synchronsprecher, Studiozeit, Audioengineering und mehrere Überprüfungsrunden hinzufügt. Aus diesem Grund evaluieren immer mehr Teams KI-Dubbing-Plattformen, insbesondere für Dubbing-Funktionen und nicht für generische „Lokalisierung“.

Die schnelle Antwort

Wenn Sie ein KI-Dubbing-Tool auswählen, bewerten Sie zuerst diese Funktionen:

Genaues Transkribieren + Timing (die Grundlage für jedes Dub)

Stimmqualität + Stimmenklonung (Markenkonsistenz über alle Sprachen hinweg)

KI-Lipsynchronisation (natürlich wirkende Mundbewegungen, insbesondere für Headshots)

Unterstützung für mehrere Sprecher (trennt Sprecher und bewahrt unterschiedliche Stimmen)

Untertitel- & Skripteditor (korrigiert ungeschickte Zeilen, ohne alles neu zu machen)

Glossar-/Terminologiekontrollen (Produktnamen, Akronyme, Fachbegriffe)

Export- + Workflow-Kontrollen (Format, Geschwindigkeit, Warteschlangen, Zusammenarbeit)

Warum das jetzt wichtig ist: Laut HubSpot glauben 93% der Vermarkter, dass Video ein wesentlicher Bestandteil ihrer Marketingstrategie ist, und Video hat sich zum Standardmedium für Produktschulung und Marketing entwickelt.

Wie funktioniert der AI-Dubbing-Prozess?

In einem typischen KI-Dubbing-Workflow führt das System folgende Schritte aus:

Transkribiert das Video in Text (Video zu Text Skript).

Übersetzt das Skript in Zielsprache (automatische Videoübersetzung).

Erzeugt Sprach-Audio (oft mit Optionen zur Stimmenklonung).

Synchronisiert das neue Audio mit dem Video-Timing (einschließlich Lipsynchronisation).

Erlaubt das Bearbeiten der Skripte/Untertitel für Genauigkeit und Ton.

Exportiert synchronisierte Videodateien.

Perso AI positioniert sein Produkt als eine KI-gestützte Plattform, die Dubbing, Übersetzung und Lipsynchronisation in einem Prozess integriert und über 32 Sprachen unterstützt.

Top 7 Funktionen, die man bei einem hochwertigen KI-Dubbing-Tool beachten sollte?

Die Qualität des Dubbings hängt nicht nur von der Übersetzungsgenauigkeit ab. Sie hängt davon ab, wie effektiv die Technologie Sprache, Timing und Bearbeitung handhabt. Verwendbare Dubs unterscheiden sich von Material, das automatisiert erscheint, auf folgende Weise.

1) Stimmenklonung (Marken-Stimmkonsistenz)

Generische Stimmen könnten das Vertrauen schwächen, wenn Ihr Erzähler oder Sprecher vor der Kamera Ihre Marke repräsentiert. Das Sprechen in mehreren Sprachen bei gleichzeitiger Beibehaltung eines erkennbaren Tones und einer erkennbaren Persönlichkeit wird durch Stimmenklonung erleichtert. Perso AI unterstützt Sprachklonung in 32 Sprachen als grundlegendes Merkmal.

Was man prüfen sollte (schnell):

Bleibt die Stimme über Szenen und Emotionen hinweg konsistent?

Klingen Pausen und Betonungen natürlich, nicht robotisch?

Klingt die Stimme bei Produktnamen ohne merkwürdige Aussprache?

2) KI-Lipsynchronisation (Der „Glaubwürdigkeitsfaktor“)

Selbst wenn die Übersetzung genau ist, können nicht übereinstimmende Mundbewegungen die Aufmerksamkeit der Zuschauer schnell brechen - insbesondere bei Headshots, Webinaren und Gründeransprachen. Perso AI listet KI-Lipsynchronisation als primäre Dubbing-Funktion.

Was man prüfen sollte:

Nahaufnahmen von Gesichtern (schwierigster Fall)

Schnellsprechende (Timing-Stresstest)

Worte mit viel Mundbewegung („p“, „b“, „m“-Laute)

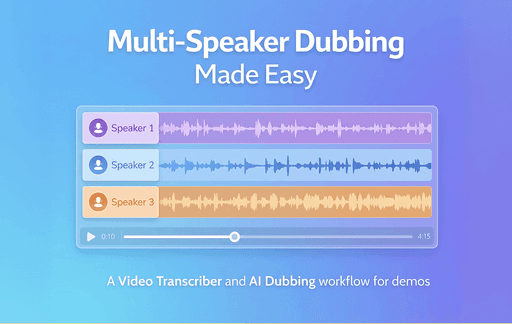

3) Unterstützung mehrerer Sprecher (Kritisch für Webinare & Interviews)

Viele Teams synchronisieren Inhalte, die keinen einzelnen Erzähler haben: Podiumsdiskussionen, Podcasts, Kundeninterviews, Schulungen mit mehreren Personen. Die Erkennung/Unterstützung mehrerer Sprecher ist ein entscheidendes Kriterium, weil sie bewahrt, wer spricht, und das Video verständlich hält. Perso AI listet die Unterstützung mehrerer Sprecher als Teil seines Dubbing-Funktionsumfangs auf.

Was man prüfen sollte:

Trennt es die Sprecher korrekt?

Können Sie für jede Person über das gesamte Video hinweg konsistente Stimmen beibehalten?

4) Skript-/Untertitelfunktion (Kontrolle, ohne alles neu zu machen)

Hochleistungsfähige Dubbings-Workflows geben Ihnen Bearbeitungskontrolle, sodass Sie Folgendes korrigieren können:

Terminologie,

Ton,

Grammatik,

ungeschickte Übersetzungen,

vor dem endgültigen Export.

Perso AI bewirbt das Skriptbearbeiten für „Grammatik- & Übersetzungsverfeinerungen“ und dessen Untertitel- & Skripteditor betont das Überprüfen und Anpassen von Übersetzungen vor der Freigabe.

Was man prüfen sollte:

Können Sie Zeilen schnell bearbeiten, ohne das ganze Video neu zu generieren?

Bleibt das Timing nach Bearbeitungen erhalten?

5) Benutzerdefiniertes Glossar (Genauigkeit der Marken- + Produktterminologie)

Für US-SaaS-Teams sind „Featuresnamen“ nicht optional. Ebenso wenig wie Compliance-Bedingungen, medizinische Begriffe oder rechtliche Formulierungen. Ein benutzerdefiniertes Glossar erzwingt konsistente Übersetzungen und hilft, Markenabweichungen zu vermeiden. Perso AI listet ein benutzerdefiniertes Glossar als Teil seines Dubbing-Workflows auf.

Was sollte von Anfang an in Ihrem Glossar enthalten sein:

Produkt-/Feature-Namen, die nicht übersetzt werden sollten

Akronyme (CRM, API, SOC 2) und wie sie ausgesprochen werden sollten

wichtige Wertversprechen und Slogan-Formulierungen

6) Verarbeitungslimits und Durchsatz (Geschwindigkeit ist ein Feature)

Wenn Sie wöchentlich Inhalte versenden, zählt der Durchsatz:

maximale Länge pro Video,

gleichzeitige Verarbeitung/Warteschlangen,

und ob Sie Projekte ohne Bereinigung speichern können.

Die Preisübersicht von Perso AI bezieht sich auf maximale Videolängen (z. B. 5/15/30 Minuten je nach Plan), Projektspeicherung und „gleichzeitige Verarbeitung“ / Warteschlangen-Konzepte.

7) Ausgabebereitschaft (Was Sie tatsächlich veröffentlichen können)

Ein gutes Dubbing-Tool sollte Ihnen Ausgabeformate bieten, die in Ihre Umgebung passen: YouTube, LMS, Produktseiten und bezahlte Social-Media-Anzeigen. Selbst wenn eine Plattform großartige Audioinhalte erstellt, entsteht Reibung, wenn Exporte nicht Ihrer Veröffentlichungspipeline entsprechen.

Was man prüfen sollte:

Exportiert es in den Standardformaten, die Sie bereits verwenden?

Sind Untertitel verfügbar, wenn Sie sie benötigen (auch wenn Sie synchronisieren)?

Traditionelles Dubbing vs. KI-Dubbing: Ein praktischer Vergleich

Hier ist eine einfache Ansicht, die Sie in den Artikel aufnehmen können, um Klarheit zu schaffen.

Faktor | Traditionelles Dubbing (typisch) | KI-Dubbing (typisch) |

Kostenstruktur | Oft nach fertiggestellten Minuten berechnet; professionelle Leistungen können in einigen Szenarien bei ca. 45 USD/Min beginnen und mit Umfang/Qualität steigen. | Abonnement/Credits oder nutzungsabhängig pro Minute; variiert je nach Plattform und Stimmqualität. |

Durchlaufzeit | Planung + Aufnahme + Bearbeitungszyklen | Schnellerer Verarbeitungs- + Bearbeitungsworkflow (abhängig von Überprüfungsanforderungen) |

Konsistenz über Sprachen hinweg | Mehrere Sprecher = schwieriger, die gleiche „Markenstimme“ zu halten | Stimmenklonung kann die Sprecheridentität über Sprachen hinweg bewahren. |

Aktualisierungen | Nachholer können langsam und teuer sein | Bearbeitungen + Neuerstellungen können schneller sein, insbesondere bei Skriptkontrollen. |

Hinweis: Die genauen Kosten variieren stark je nach Anbieter, Inhaltstyp und Qualitätsstufe. Der Punkt der Tabelle besteht darin, den Lesern zu helfen zu verstehen, wie die Preisgestaltung funktioniert, nicht um einen einzigen universellen Satz zu versprechen.

Ihre Dubbing-Feature-Checkliste

Funktion | Wie „gut“ aussieht | Schnelltest |

Transkriptionsgenauigkeit | Sauberes Transkript mit korrekter Zeichensetzung und Begriffen | 1 Min Clip mit Akronymen + Produktnamen |

Übersetzungsqualität | Natürliche Formulierung, nicht wörtlich | Einen zweisprachigen Prüfer fragen, um 1–10 zu bewerten |

Stimmenklonung | Gleiche Persönlichkeit/Ton; stabiles Tempo | 2 Clips vergleichen: ruhig vs. energiegeladen |

KI-Lipsynchronisation | Kein merklicher Drift; bewältigt schnelles Sprechen | Nahaufnahme von Sprechern |

Skripteditor | Begriffe bearbeiten und schnell neu erzeugen | 5 Begriffe korrigieren und neu synchronisieren |

Mehrere Sprecher | Sprechertrennung bleibt konsistent | Ausschnitt eines Webinars mit 2–3 Sprechern |

Glossar | Konsistente Funktionsnamen über Videos hinweg | 20 Begriffe hinzufügen und erneut ausführen |

Warum lohnt sich Dubbing?

Auf YouTube stellten Ersteller von Inhalten mit mehrsprachigen Audiotracks fest, dass über 25 % der Wiedergabezeit von Zuschauern in der nicht-primären Sprache des Videos (Durchschnitt) stammten. Das „beweist“ zwar nicht, dass Dubbing für jedes Unternehmen funktionieren wird, aber es zeigt, warum sprachbereites Audio ein echtes zusätzliches Publikum erschließen kann.

Fazit

Wenn Sie Videos für einen ersten Start in den USA erstellen und anschließend weltweit skalieren möchten, ist es am besten, Dubbing-Lösungen anhand von Funktionen zu bewerten, die die Qualität beeinflussen: Stimmenklonung, Lipsynchronisation, Unterstützung mehrerer Sprecher, Skriptbearbeitung und Glossarenforcement. Plattformen wie Perso AI, die diese Funktionen in einem einzigen Prozess integrieren, ermöglichen eine schnellere Lokalisierung, ohne separate Produktionsprojekte für jede Sprache zu erstellen.

Häufig gestellte Fragen

1) Was ist der Unterschied zwischen KI-Dubbing und Untertiteln?

Untertitel zeigen übersetzten Text. KI-Dubbing generiert übersetztes Audio (oft mit Stimmenklonung und Lipsynchronisation), damit Zuschauer natürlich zuhören können.

2) Funktioniert KI-Dubbing für Webinare mit mehreren Sprechern?

Es kann funktionieren, wenn die Plattform die Handhabung mehrerer Sprecher unterstützt, sodass jede Stimme einzigartig bleibt.

3) Wie halten wir Produktbegriffe in jeder Sprache konsistent?

Verwenden Sie ein benutzerdefiniertes Glossar, um Produktnamen, Akronyme und Markenphrasen zu sichern.

4) Ist KI-Lipsynchronisation immer notwendig?

Nicht immer. Es ist besonders wichtig für Sprecher vor der Kamera und Nahaufnahmen. Bei Bildschirmaufnahmen kann es weniger kritisch sein, bietet aber dennoch eine Qualitätsverbesserung, wenn verfügbar.

5) Wie verbessern wir die Qualität, ohne das Team zu verlangsamen?

Verwenden Sie einen schlanken Überprüfungsprozess: Korrigieren Sie wichtige Zeilen im Skripteditor, erzwingen Sie Glossarbegriffe und führen Sie eine schnelle Stichprobenüberprüfung von Nahaufnahmen auf Lipsynchronisation durch.

KI-Dubbing-Funktionen, die wirklich wichtig sind: Ein praktischer Leitfaden

Ihr US-Team schließt ein Produktdemo-Video auf Englisch ab. Nächste Woche fragt der Vertrieb nach Spanisch. Der Support möchte Japanisch für APAC-Kunden. Das Marketing möchte dieselbe Stimme und das gleiche Tempo in jeder Sprache, damit die Marke immer noch „wie Sie klingt“.

Traditionelles Dubbing kann pro Sprache Wochen dauern und wird schnell teuer, wenn man Übersetzer, Synchronsprecher, Studiozeit, Audioengineering und mehrere Überprüfungsrunden hinzufügt. Aus diesem Grund evaluieren immer mehr Teams KI-Dubbing-Plattformen, insbesondere für Dubbing-Funktionen und nicht für generische „Lokalisierung“.

Die schnelle Antwort

Wenn Sie ein KI-Dubbing-Tool auswählen, bewerten Sie zuerst diese Funktionen:

Genaues Transkribieren + Timing (die Grundlage für jedes Dub)

Stimmqualität + Stimmenklonung (Markenkonsistenz über alle Sprachen hinweg)

KI-Lipsynchronisation (natürlich wirkende Mundbewegungen, insbesondere für Headshots)

Unterstützung für mehrere Sprecher (trennt Sprecher und bewahrt unterschiedliche Stimmen)

Untertitel- & Skripteditor (korrigiert ungeschickte Zeilen, ohne alles neu zu machen)

Glossar-/Terminologiekontrollen (Produktnamen, Akronyme, Fachbegriffe)

Export- + Workflow-Kontrollen (Format, Geschwindigkeit, Warteschlangen, Zusammenarbeit)

Warum das jetzt wichtig ist: Laut HubSpot glauben 93% der Vermarkter, dass Video ein wesentlicher Bestandteil ihrer Marketingstrategie ist, und Video hat sich zum Standardmedium für Produktschulung und Marketing entwickelt.

Wie funktioniert der AI-Dubbing-Prozess?

In einem typischen KI-Dubbing-Workflow führt das System folgende Schritte aus:

Transkribiert das Video in Text (Video zu Text Skript).

Übersetzt das Skript in Zielsprache (automatische Videoübersetzung).

Erzeugt Sprach-Audio (oft mit Optionen zur Stimmenklonung).

Synchronisiert das neue Audio mit dem Video-Timing (einschließlich Lipsynchronisation).

Erlaubt das Bearbeiten der Skripte/Untertitel für Genauigkeit und Ton.

Exportiert synchronisierte Videodateien.

Perso AI positioniert sein Produkt als eine KI-gestützte Plattform, die Dubbing, Übersetzung und Lipsynchronisation in einem Prozess integriert und über 32 Sprachen unterstützt.

Top 7 Funktionen, die man bei einem hochwertigen KI-Dubbing-Tool beachten sollte?

Die Qualität des Dubbings hängt nicht nur von der Übersetzungsgenauigkeit ab. Sie hängt davon ab, wie effektiv die Technologie Sprache, Timing und Bearbeitung handhabt. Verwendbare Dubs unterscheiden sich von Material, das automatisiert erscheint, auf folgende Weise.

1) Stimmenklonung (Marken-Stimmkonsistenz)

Generische Stimmen könnten das Vertrauen schwächen, wenn Ihr Erzähler oder Sprecher vor der Kamera Ihre Marke repräsentiert. Das Sprechen in mehreren Sprachen bei gleichzeitiger Beibehaltung eines erkennbaren Tones und einer erkennbaren Persönlichkeit wird durch Stimmenklonung erleichtert. Perso AI unterstützt Sprachklonung in 32 Sprachen als grundlegendes Merkmal.

Was man prüfen sollte (schnell):

Bleibt die Stimme über Szenen und Emotionen hinweg konsistent?

Klingen Pausen und Betonungen natürlich, nicht robotisch?

Klingt die Stimme bei Produktnamen ohne merkwürdige Aussprache?

2) KI-Lipsynchronisation (Der „Glaubwürdigkeitsfaktor“)

Selbst wenn die Übersetzung genau ist, können nicht übereinstimmende Mundbewegungen die Aufmerksamkeit der Zuschauer schnell brechen - insbesondere bei Headshots, Webinaren und Gründeransprachen. Perso AI listet KI-Lipsynchronisation als primäre Dubbing-Funktion.

Was man prüfen sollte:

Nahaufnahmen von Gesichtern (schwierigster Fall)

Schnellsprechende (Timing-Stresstest)

Worte mit viel Mundbewegung („p“, „b“, „m“-Laute)

3) Unterstützung mehrerer Sprecher (Kritisch für Webinare & Interviews)

Viele Teams synchronisieren Inhalte, die keinen einzelnen Erzähler haben: Podiumsdiskussionen, Podcasts, Kundeninterviews, Schulungen mit mehreren Personen. Die Erkennung/Unterstützung mehrerer Sprecher ist ein entscheidendes Kriterium, weil sie bewahrt, wer spricht, und das Video verständlich hält. Perso AI listet die Unterstützung mehrerer Sprecher als Teil seines Dubbing-Funktionsumfangs auf.

Was man prüfen sollte:

Trennt es die Sprecher korrekt?

Können Sie für jede Person über das gesamte Video hinweg konsistente Stimmen beibehalten?

4) Skript-/Untertitelfunktion (Kontrolle, ohne alles neu zu machen)

Hochleistungsfähige Dubbings-Workflows geben Ihnen Bearbeitungskontrolle, sodass Sie Folgendes korrigieren können:

Terminologie,

Ton,

Grammatik,

ungeschickte Übersetzungen,

vor dem endgültigen Export.

Perso AI bewirbt das Skriptbearbeiten für „Grammatik- & Übersetzungsverfeinerungen“ und dessen Untertitel- & Skripteditor betont das Überprüfen und Anpassen von Übersetzungen vor der Freigabe.

Was man prüfen sollte:

Können Sie Zeilen schnell bearbeiten, ohne das ganze Video neu zu generieren?

Bleibt das Timing nach Bearbeitungen erhalten?

5) Benutzerdefiniertes Glossar (Genauigkeit der Marken- + Produktterminologie)

Für US-SaaS-Teams sind „Featuresnamen“ nicht optional. Ebenso wenig wie Compliance-Bedingungen, medizinische Begriffe oder rechtliche Formulierungen. Ein benutzerdefiniertes Glossar erzwingt konsistente Übersetzungen und hilft, Markenabweichungen zu vermeiden. Perso AI listet ein benutzerdefiniertes Glossar als Teil seines Dubbing-Workflows auf.

Was sollte von Anfang an in Ihrem Glossar enthalten sein:

Produkt-/Feature-Namen, die nicht übersetzt werden sollten

Akronyme (CRM, API, SOC 2) und wie sie ausgesprochen werden sollten

wichtige Wertversprechen und Slogan-Formulierungen

6) Verarbeitungslimits und Durchsatz (Geschwindigkeit ist ein Feature)

Wenn Sie wöchentlich Inhalte versenden, zählt der Durchsatz:

maximale Länge pro Video,

gleichzeitige Verarbeitung/Warteschlangen,

und ob Sie Projekte ohne Bereinigung speichern können.

Die Preisübersicht von Perso AI bezieht sich auf maximale Videolängen (z. B. 5/15/30 Minuten je nach Plan), Projektspeicherung und „gleichzeitige Verarbeitung“ / Warteschlangen-Konzepte.

7) Ausgabebereitschaft (Was Sie tatsächlich veröffentlichen können)

Ein gutes Dubbing-Tool sollte Ihnen Ausgabeformate bieten, die in Ihre Umgebung passen: YouTube, LMS, Produktseiten und bezahlte Social-Media-Anzeigen. Selbst wenn eine Plattform großartige Audioinhalte erstellt, entsteht Reibung, wenn Exporte nicht Ihrer Veröffentlichungspipeline entsprechen.

Was man prüfen sollte:

Exportiert es in den Standardformaten, die Sie bereits verwenden?

Sind Untertitel verfügbar, wenn Sie sie benötigen (auch wenn Sie synchronisieren)?

Traditionelles Dubbing vs. KI-Dubbing: Ein praktischer Vergleich

Hier ist eine einfache Ansicht, die Sie in den Artikel aufnehmen können, um Klarheit zu schaffen.

Faktor | Traditionelles Dubbing (typisch) | KI-Dubbing (typisch) |

Kostenstruktur | Oft nach fertiggestellten Minuten berechnet; professionelle Leistungen können in einigen Szenarien bei ca. 45 USD/Min beginnen und mit Umfang/Qualität steigen. | Abonnement/Credits oder nutzungsabhängig pro Minute; variiert je nach Plattform und Stimmqualität. |

Durchlaufzeit | Planung + Aufnahme + Bearbeitungszyklen | Schnellerer Verarbeitungs- + Bearbeitungsworkflow (abhängig von Überprüfungsanforderungen) |

Konsistenz über Sprachen hinweg | Mehrere Sprecher = schwieriger, die gleiche „Markenstimme“ zu halten | Stimmenklonung kann die Sprecheridentität über Sprachen hinweg bewahren. |

Aktualisierungen | Nachholer können langsam und teuer sein | Bearbeitungen + Neuerstellungen können schneller sein, insbesondere bei Skriptkontrollen. |

Hinweis: Die genauen Kosten variieren stark je nach Anbieter, Inhaltstyp und Qualitätsstufe. Der Punkt der Tabelle besteht darin, den Lesern zu helfen zu verstehen, wie die Preisgestaltung funktioniert, nicht um einen einzigen universellen Satz zu versprechen.

Ihre Dubbing-Feature-Checkliste

Funktion | Wie „gut“ aussieht | Schnelltest |

Transkriptionsgenauigkeit | Sauberes Transkript mit korrekter Zeichensetzung und Begriffen | 1 Min Clip mit Akronymen + Produktnamen |

Übersetzungsqualität | Natürliche Formulierung, nicht wörtlich | Einen zweisprachigen Prüfer fragen, um 1–10 zu bewerten |

Stimmenklonung | Gleiche Persönlichkeit/Ton; stabiles Tempo | 2 Clips vergleichen: ruhig vs. energiegeladen |

KI-Lipsynchronisation | Kein merklicher Drift; bewältigt schnelles Sprechen | Nahaufnahme von Sprechern |

Skripteditor | Begriffe bearbeiten und schnell neu erzeugen | 5 Begriffe korrigieren und neu synchronisieren |

Mehrere Sprecher | Sprechertrennung bleibt konsistent | Ausschnitt eines Webinars mit 2–3 Sprechern |

Glossar | Konsistente Funktionsnamen über Videos hinweg | 20 Begriffe hinzufügen und erneut ausführen |

Warum lohnt sich Dubbing?

Auf YouTube stellten Ersteller von Inhalten mit mehrsprachigen Audiotracks fest, dass über 25 % der Wiedergabezeit von Zuschauern in der nicht-primären Sprache des Videos (Durchschnitt) stammten. Das „beweist“ zwar nicht, dass Dubbing für jedes Unternehmen funktionieren wird, aber es zeigt, warum sprachbereites Audio ein echtes zusätzliches Publikum erschließen kann.

Fazit

Wenn Sie Videos für einen ersten Start in den USA erstellen und anschließend weltweit skalieren möchten, ist es am besten, Dubbing-Lösungen anhand von Funktionen zu bewerten, die die Qualität beeinflussen: Stimmenklonung, Lipsynchronisation, Unterstützung mehrerer Sprecher, Skriptbearbeitung und Glossarenforcement. Plattformen wie Perso AI, die diese Funktionen in einem einzigen Prozess integrieren, ermöglichen eine schnellere Lokalisierung, ohne separate Produktionsprojekte für jede Sprache zu erstellen.

Häufig gestellte Fragen

1) Was ist der Unterschied zwischen KI-Dubbing und Untertiteln?

Untertitel zeigen übersetzten Text. KI-Dubbing generiert übersetztes Audio (oft mit Stimmenklonung und Lipsynchronisation), damit Zuschauer natürlich zuhören können.

2) Funktioniert KI-Dubbing für Webinare mit mehreren Sprechern?

Es kann funktionieren, wenn die Plattform die Handhabung mehrerer Sprecher unterstützt, sodass jede Stimme einzigartig bleibt.

3) Wie halten wir Produktbegriffe in jeder Sprache konsistent?

Verwenden Sie ein benutzerdefiniertes Glossar, um Produktnamen, Akronyme und Markenphrasen zu sichern.

4) Ist KI-Lipsynchronisation immer notwendig?

Nicht immer. Es ist besonders wichtig für Sprecher vor der Kamera und Nahaufnahmen. Bei Bildschirmaufnahmen kann es weniger kritisch sein, bietet aber dennoch eine Qualitätsverbesserung, wenn verfügbar.

5) Wie verbessern wir die Qualität, ohne das Team zu verlangsamen?

Verwenden Sie einen schlanken Überprüfungsprozess: Korrigieren Sie wichtige Zeilen im Skripteditor, erzwingen Sie Glossarbegriffe und führen Sie eine schnelle Stichprobenüberprüfung von Nahaufnahmen auf Lipsynchronisation durch.

Weiterlesen

Alle durchsuchen

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618

PRODUKT

ANWENDUNGSFALL

ESTsoft Inc. 15770 Laguna Canyon Rd #250, Irvine, CA 92618